Desktop AI e Open-Source AI: O PC Vira Laboratório, o Código Vira Nação

- Desktop AI deixou de ser "demo de feira": é um ecossistema de ferramentas, agentes, runtimes e modelos a correr localmente.

- Open-source AI está a acelerar por dois motores: eficiência (modelos menores/rápidos) e soberania (controle de dados e infraestrutura).

- Agentes e protocolos (ex.: MCP e padrões emergentes) empurram a IA do "texto bonito" para a "acção útil".

- O risco cresce à mesma velocidade: interfaces web locais, plugins e pipelines exigem disciplina de segurança e actualizações rápidas.

- O "PC comum" já não é só terminal: começa a ser laboratório, oficina e, em alguns casos, mini-datacenter.

Desktop AI e Open-Source AI: o PC vira laboratório, o código vira nação

Há semanas em que a tecnologia avança como maré: sobe sem pedir licença, ocupa a praia inteira e deixa-nos a olhar para o horizonte com a estranha sensação de que o mundo mudou enquanto bebíamos um café. Esta semana, o sinal mais claro não veio apenas de um novo modelo ou de uma ferramenta "milagrosa". Veio da soma: Desktop AI + open-source + agentes + frameworks + hardware. Ou seja: a IA a sair do palco distante e a entrar pela porta do escritório.

1) Desktop AI: do brinquedo ao ecossistema

Durante muito tempo, "IA no PC" era sinónimo de duas coisas: entusiasmo e frustração. Entusiasmo porque a ideia de correr modelos localmente tem o sabor da liberdade. Frustração porque era fácil tropeçar em VRAM, drivers, dependências e configurações que pareciam escritas em latim medieval.

O que está a mudar — e de forma visível — é a maturidade do ecossistema:

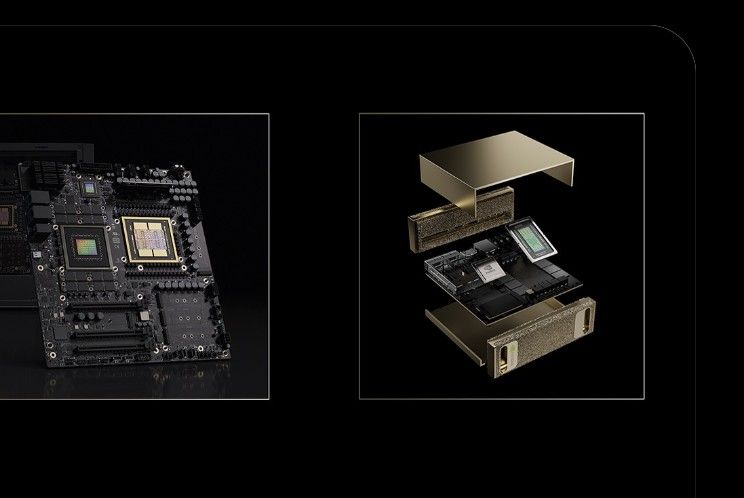

- Runtimes mais eficientes (CPU+GPU), com gestão de memória mais agressiva e compatibilidades mais estáveis.

- Stacks "local-first" com instaladores e Docker stacks que já trazem modelos, vector DB e UI prontos a usar.

- Ferramentas com foco em workflow: já não é só "fazer o modelo responder", é integrar o modelo num processo real.

O resultado é simples e poderoso: o desktop deixa de ser um "cliente" da IA e passa a ser um "local de produção" de IA. Não apenas para brincar — mas para fazer trabalho sério: relatórios, triagem de informação, suporte técnico, automação de tarefas repetitivas, apoio à programação, e até agentes que interagem com ficheiros e aplicações.

2) Open-Source AI: soberania, eficiência e velocidade

Se a nuvem é o grande império, o open-source é o arquipélago: múltiplas ilhas, múltiplas comunidades, múltiplas línguas — e uma espécie de contrato moral que diz: "se aprendeste algo, partilha."

Nesta semana, a tendência mais relevante não é "um modelo X superou um modelo Y". É mais estrutural: o open-source está a criar a sua própria infraestrutura de sobrevivência, com ferramentas que tornam o ciclo de vida completo — do download ao deploy — cada vez mais previsível.

Três forças empurram este movimento:

- Soberania: dados sensíveis, compliance, auditoria, privacidade. Local é controlo. Open-source é verificabilidade.

- Eficiência: modelos mais compactos, quantização mais madura, inferência optimizada, e "bom o suficiente" para casos reais.

- Velocidade comunitária: quando o mundo inteiro depura, melhora e documenta, o progresso deixa de depender de um único "roadmap corporativo".

A grande consequência: cresce a viabilidade de soluções híbridas, onde parte do processamento é local (privado e rápido) e parte é remoto (quando necessário), mas com um princípio soberano: o utilizador decide o que sai e o que fica.

3) Agentes: a IA deixa de "falar" e começa a "fazer"

O conceito de "agente" é, em parte, moda. Mas também é inevitabilidade. Porque se a IA só escreve texto, ela fica confinada ao papel. Quando a IA acede a ferramentas — ficheiros, APIs, IDEs, bases de dados, automação do sistema — ela entra no território do trabalho real.

O que vemos nesta fase é a corrida por padrões e integração:

- Protocolos de contexto e "tool calling" mais estruturados, que reduzem improviso e aumentam previsibilidade.

- Frameworks de orquestração (multi-agente, workflow, RAG) que transformam ideias em pipelines repetíveis.

- Integração com IDEs: o agente deixa de ser "chat" e passa a ser "colega de equipa" dentro do editor.

Para quem constrói sistemas, isto abre uma avenida: agentes para triagem de tickets, análise de logs, geração de playbooks, suporte à decisão, auditoria de configuração, documentação viva — e, sim, programação assistida, mas sem a fantasia do "programador instantâneo". O agente não substitui a mente; amplifica-a. E o amplificador exige disciplina.

4) Ferramentas e frameworks: a "mão invisível" do progresso

Modelos são manchetes. Ferramentas são destino. Nesta semana, o que importa para o developer é que as camadas intermédias estão a ficar melhores: construtores de fluxos, bibliotecas de inferência, interfaces locais, observabilidade, caches, vector stores e kits de "self-hosting" que reduzem a fricção.

O efeito é quase físico: o tempo entre a ideia e o protótipo encurta. E quando encurta o tempo, aumenta o número de tentativas. E quando aumentam as tentativas, nasce inovação.

5) Segurança: a conta que chega sempre

Desktop AI e open-source trazem liberdade — mas também superfície de ataque. UIs web locais, plugins, stacks Docker, modelos descarregados de fontes duvidosas, dependências com versões antigas: tudo isso é combustível para incidentes.

A regra de ouro para quem quer IA local "com cabeça":

- Actualizar versões e ler changelogs com atenção.

- Isolar serviços (containers, permissões mínimas, redes separadas quando possível).

- Evitar expor interfaces de gestão para a Internet.

- Guardar logs e métricas (observabilidade não é luxo; é defesa).

A autonomia não é apenas poder. É também responsabilidade. E na era dos agentes, uma falha não é só "um bug"; pode ser "uma acção errada". Quem constrói tem de pensar como engenheiro e como guardião.

6) O que fazer já: um plano prático para o developer

Se quer tirar proveito desta onda, sem te afogares no hype, aqui vai um plano simples e eficaz:

- Escolhe um caso de uso real (logs, tickets, documentos técnicos, suporte, automação de tarefas).

- Define o grau de soberania: o que fica local, o que pode ir para cloud (se for necessário).

- Constrói uma stack mínima: modelo local + UI + armazenamento (vector DB se precisares) + logging.

- Adiciona ferramentas: ficheiros, APIs internas, scripts, rotinas — e limita permissões.

- Instrumenta: mede latência, qualidade, custos, falhas, e melhora com iteração.

A beleza disto é que é incremental. Não precisas de um império para começar. Precisa de um fio, uma agulha e a coragem de coser o futuro ao presente.

Conclusão: o PC volta a ser "pessoal"

Durante anos, o computador pessoal foi empurrado para o papel de terminal: um ecrã bonito para aceder a serviços distantes. Desktop AI e open-source AI estão a inverter isso. O PC volta a ser pessoal — porque volta a ter poder local.

E quando o poder regressa, regressa também a liberdade: liberdade de experimentar, de auditar, de adaptar, de criar. A verdadeira inovação nasce aí — não no marketing, mas no laboratório íntimo onde um programador testa ideias, corrige erros, e insiste até o impossível ficar apenas… "um pouco mais demorado".

Referências e apontadores

- Documentação e projectos de inferência local: llama.cpp, Ollama, UIs de workflows e stacks "local-first".

- Frameworks de orquestração e agentes: stacks de workflow, ferramentas de RAG, e padrões de "tool calling".

- Observabilidade e disciplina de produção: logging, tracing e métricas para aplicações LLM/agentic.

- Boletins e compilações comunitárias: repos "awesome", releases e changelogs semanais dos projectos.

- Boas práticas de segurança: isolamento de serviços, actualizações e redução de superfície exposta.